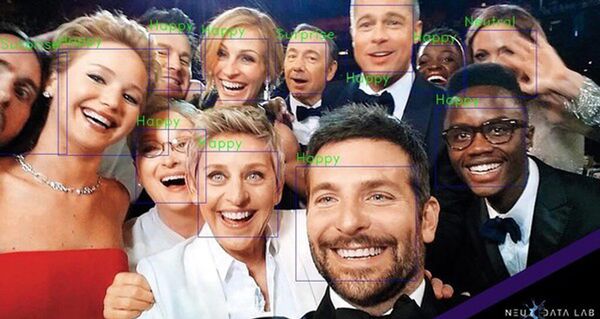

第一阶段拍摄了6个小时的视频,视频中录下了有10个专业演员的(在此过程他们都有脉搏器)情绪:高兴,惊讶,凶恶,忧郁、恐惧和厌恶。

然后注释者们研究所得到的视频,他们指出被观察者在某些具体时间的情绪。

接下来是选出160个小时的视频,在视频中记录下各种场景中的在互相交流的人们。收集到的数据成为训练神经网络识别人类表情的方法。

这些方法注意到了声音(音高、音色、音量、言语的停顿)、情绪基调、语义、面部表情、肢体运动的速度和方向、部分肢体的位置、在皮肤颜色变化时的心率,胸部运动时的呼吸,人的性别和年龄及其脸上的眼镜、八字胡和络腮胡。

已准备使用的新研发可能对商业、广告、安全和医疗以及其它重要的正确理解人类行为及其情绪的领域有所帮助。

京公网安备11010502053235号

京公网安备11010502053235号